Te disseram que o Big Data morreu… Mas, ele vai voltar

O big data já voltou e você talvez nem tenha se tocado. Escondido e esquecido, este será novamente o trabalho da vez!

Mesmo que você não seja da área técnica, você talvez em algum momento ouviu falar no termo Big Data. Pois é, aquela época em que todo negócio na internet se gabava falando que tinha uma tonelada e meia de dados e informações de usuários, e que da noite pro dia, sem ninguém perceber todo mundo parou de falar e ninguém deu falta. Hoje, eu te explico por que nasceu, por quê morreu e por quê o termo big data vai voltar.

O início de tudo: Big Data Analytics

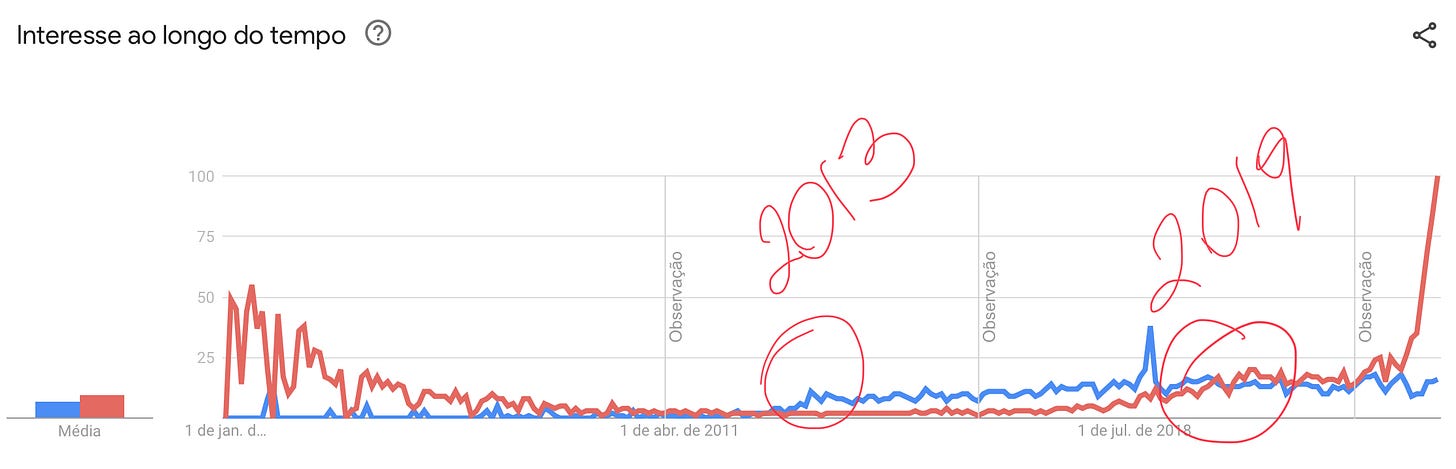

Talvez já faça tanto tempo que você ouviu falar de big data, que talvez você nem saiba ao certo quando esse negócio pegou de fato. Mas, a verdade é que o Big Data ganhou seus primeiros holofotes em meados de 2013 pela primeira vez.

E daí você se pergunta, mas o que diabos aconteceu em 2013? Bom, tem duas coisas muito icônicas que qualquer um vai entender que posso usar para mostrar por quê esse termo ficou tão popular por esse período.

O primeiro deles é que foi bem nessa época que o Facebook começou a usar algoritmos para apresentar conteúdo aos seus usuários baseado nos dados de navegação e interação dentro da plataforma. Os algoritmos de recomendação na época, que nos dias de hoje chamaríamos de inteligência artificial, eram cases de palestras e mais palestras sobre como esse gigante detentor do maior banco de dados do mundo sobre pessoas, usou esse mesmo banco de dados para gerar mais tráfego e mais ainda: vendas com os seus ads.

Foi essa análise de dados gerando milhões em receita de vendas de propagandas no site que fez com que o conceito big data analytics vira-se o principal objetivo de todo negócio na época.

Um segundo fator interessante, e que se uniria a teorias da conspiração foi o fato de a empresa Cambridge Analytica ter sido fundada neste ano. Para quem não conhece a Cambridge Analytica, essa empresa está por trás de um dos maiores escândalos de manipulação eleitoral da história. Todos os detalhes foram contados através de um documentário no Netflix chamado Privacidade Hackeada, mas eu vou resumir aqui para vocês.

Naquela época o Facebook não era tão cuidadoso com os dados que obtinham de seus usuários, e por isso era possível ter acesso com uma simples API com a própria permissão do Facebook. O que a Cambridge Analytica fez, foi usar esse big data para mapear a orientação política das pessoas e com - dizem os rumores - a ajuda do próprio Facebook ou do seu algoritmo, fazer as campanhas chegarem de forma orgânica ou inorgânica em todo mundo.

Bom, seja lá qual história do big data você escolha, o fato é de que nessa época o mundo entendeu que quem tinha os dados, tinha o domínio. Inclusive o pico de buscas por Big Data em 2018 acredite ou não, é no mesmo ano em que o The New York Times e o The Observer publicam o furo jornalístico anunciando essa trama toda.

O conceito de big data

Se você leu até aqui, entendeu que por mais chato que o assunto bancos de dados possa parecer, ele é de fato relevante na sua vida, você queira ou não. É o que diz aquela velha frase:

Você pode ignorar a realidade, mas não pode ignorar as consequências de ignorar a realidade.

E, mesmo que ninguém esteja falando sobre Big Data, saiba que ele ainda existe e você continua alimentando esse monstro. E isso acontece pela própria definição do que é Big Data. Segundo o ChatGPT: “Big data é um termo que se refere a conjuntos de dados extremamente grandes e complexos que não podem ser facilmente gerenciados, processados ou analisados com ferramentas tradicionais de processamento de dados. Esses conjuntos de dados geralmente têm várias fontes e formatos, como dados de sensores, registros de transações, mídias sociais, informações de clientes, entre outros.”

É amiguinhos, entenderam? O Big Data é um trabuco tão difícil de lidar, que somente máquinas e algoritmos complexos conseguiriam fazer essa montanha de dados virar informação.

Não fosse o suficiente, a característica fundamental do big data é a chamada tríade dos "3 V's": volume, velocidade e variedade. O volume se refere à imensa quantidade de dados gerados diariamente; a velocidade representa a velocidade com que os dados são criados e precisam ser processados; e a variedade engloba a diversidade de fontes e formatos de dados.

E é por isso amigos que o Big Data com o tempo deu lugar ao tema que o faria sumir do mapa: inteligência artificial. Pois quem melhor para lidar com todo esse processamento do que um algoritmo inteligente?

E por isso, por mais que big data ainda fosse um conceito importante, vimos várias empresas que anunciaram ter big data sucumbirem por não conseguirem fazer absolutamente nada com os seus próprios dados. Na angústia de não conseguirem aplicar o big data analytics de suas empresas para converter em vendas viraram-se para aquilo que parecia ser a única solução: ter cientistas de dados para criar modelos que pudessem aprender a lidar com esses gigantes bancos de dados.

É exatamente nessa época, por volta de 2019 que vemos uma virada no mercado de trabalho na busca por cientistas e engenheiros de dados capazes de dar significado a tudo que foi coletado em todos os anos anteriores e inteligência artificial passa a ser novamente o item mais buscado da internet.

A volta dos que não foram: volume de dados

Corta para fim de 2022, lançamento do ChatGPT. O maior lançamento digital sem nenhuma propaganda da história. Simplesmente o que transformou inteligência artificial de um conceito de ficção científica em realidade. Mais relevante que a revolução de clouds.

Para quem não entende ou sabe como o ChatGPT funciona, recomendo a leitura deste post simplificado descrevendo os pormenores de como essa tecnologia funciona. Para você que já conhece, você sabe onde eu quero chegar: ChatGPT não existem sem Big Data.

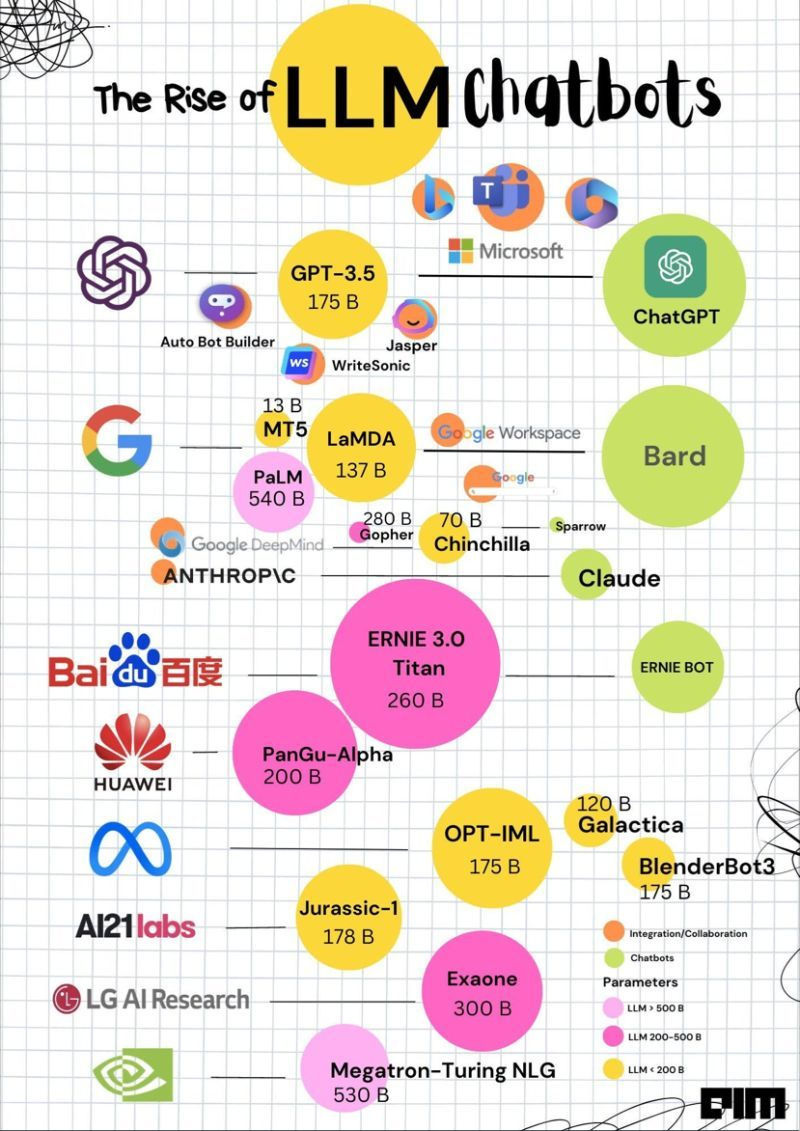

Com o que conhecemos hoje por Generative AI, ou GenAI para os íntimos, não há mais dúvidas de que os detentores de dados irão ter as ferramentas mais completas. E isso acontece pela própria definição do GPT. Os modelos de GPT de empresas diferentes se comparam usando o mesmo critério: número de parâmetros, e são muitos parâmetros. Do nível que ninguém em 2013 quando falava de big data analytics achou possível cobrir.

O ChatGPT 3.5, antecessor do 4, já possuía 175 bilhões de parâmetros. E é por isso que o conceito de big data continua vivo, porém com outro nome: parâmetros.

Isso acontece porque os novos modelos de GenAI tentam de alguma forma simplificar o mundo ao redor deles com tokens da realidade. Esses tokens são derivações destes enormes bancos de dados de informações dos 4 cantos da internet. O que ninguém tem falado é que o rápido crescimento desses modelos capazes de dar sentido e significado a tantos dados não estruturados é devido a comunidade científica aberta e a participação de grandes empresas como Meta, Google, Nvidia e OpenAI contribuindo com a capacidade de processamento necessário para rodar modelos como estes.

E agora que é possível contratar ou rodar esses modelos já descobertos e as vezes até mesmo pré-treinados, voltamos novamente ao dilema de qualquer negócio: se a inteligência artificial já não é mais um diferencial, o que será?

Resposta: dados.

O retorno e os desafios do big data

Pois é, chegamos até aqui e é agora que eu coloco o meu na reta e afirmo que o Big Data voltou a ser relevante, e cada vez mais matérias sobre como gestão de dados, coleta de informações e privacidade serão tema relevante.

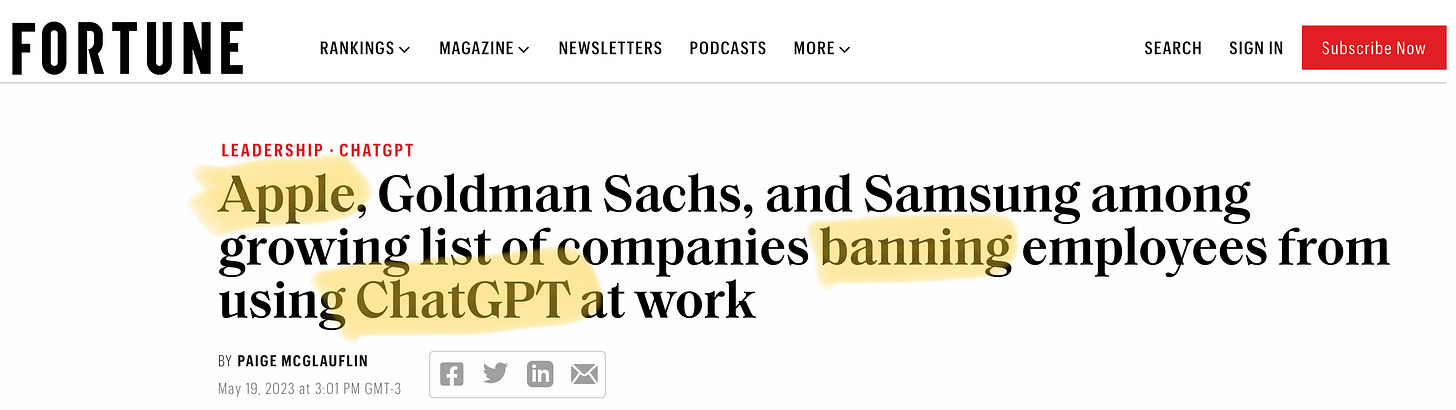

E os sinais estão por todos os lados. A própria OpenAI, criadora do ChatGPT já disse que está trabalhando junto com a Microsoft para criar uma versão de seu modelo que respeite a privacidade dos dados dos usuários, não agregando os mesmos no treinamento geral da ferramenta. Ou seja, as empresas, como a Apple que proibiu seus funcionários de usarem o ChatGPT, entenderam que seus dados são valiosos demais para estarem rodando por aí de forma não governada dentro de modelos desconhecidos na internet.

Então se você lendo isto aqui está buscando qual trabalho é a prova de futuro, mesmo sabendo que isso não existe, é possível afirmar que engenharia de dados assim como ciência de dados vão continuar em alta por algum tempo, mesmo que modelos de inteligência artificial consigam capturar e aprender sozinha com várias informações soltas na internet. Big Data is back baby, renascida como a Fênix.

Acontecendo no Mundo

Nova York liberou ChatGPT nas escolas

A cidade tinha criado uma política para banir o ChatGPT das escolas públicas e agora ela voltou atrás, o que eu acho uma excelente notícia para o futuro da educação!

Empresas

Você que tá criando o AlgumaCoisaGPT, fica ligado!!

A OpenAI está numa labuta para poder registrar a marca GPT e vir atrás de todo mundo que andou surfando a onda da GPTificação do mundo. E ela pode acabar conseguindo!

É isso que aponta o MIT Technology Review. Segundo eles, embora a AI generativa tenha seu lugar ao sol daqui para frente, as indústrias irão necessitar cada vez mais de tecnologias de inteligência cada vez mais especializadas.

Meta abre as jóias da casa e Google acha ruim

De todos os grandes players de inteligência artificial, a Meta foi quem manteve a postura de manter grande parte dos seus projetos e pesquisas abertas. Hoje abre mais uma ferramenta relevante: a de chatbots. E o Google começa a achar o movimento perigoso.

OpenAI vai deixar você limpar seus dados do ChatGPT

A Wired escreveu uma matéria sobre como deletar seus dados de dentro do ChatGPT, ou do GPT no geral. A informação vem depois de várias conversas polêmicas sobre o modelo ter se utilizados de vários dados sem o consentimento claro de pessoas e empresas.

Ferramentas

Números que todo desenvolvedor que usa ChatGPT deve saber

A Anyscale compartilhou os números de modelos que usam como referência, por que o número é importante e como usá-lo a seu favor.

Uma ferramenta bem legal para comparar a geração de imagens dos diferentes modelos que existem: stable diffusion, dali.e etc.