Não tem computador suficiente pra todo mundo

O que era inimaginável, está acontecendo há 12 meses sem você perceber: está difícil conseguir processador pra todo mundo criar AI.

Inteligência Artificial é legal e tudo mais, mas você sabe quanto custa para o ChatGPT ficar de pé todo dia de graça para você? Estima-se que uma média de R$3.000.000 por dia. Impressionante dado que o serviço também pode ser utilizado de graça por muita gente, não é?

No Google IO desse ano, o evento de lançamento de produtos do Google, foi anunciada uma atualização grande do buscador para atender as novas expectativas dos usuários, que não quer ficar clicando um link de cada vez. Mas, no mesmo anúncio eles indicaram que vão ir soltando o produto até o final do ano. O motivo eu já suspeito: falta de capacidade de computadores e o quão caro vai ser deixar essa operação rodando gratuitamente.

Não imaginava que uma ferramenta de texto ia ser tão cara assim? Eu te explico um pouco dos econômicos por detrás do mercado de AI e porque termos esses recursos disponíveis via APIs com custo acessível ajudam a levar AI para mais negócios.

O maior perigo para empresas de AI é a falta de computadores

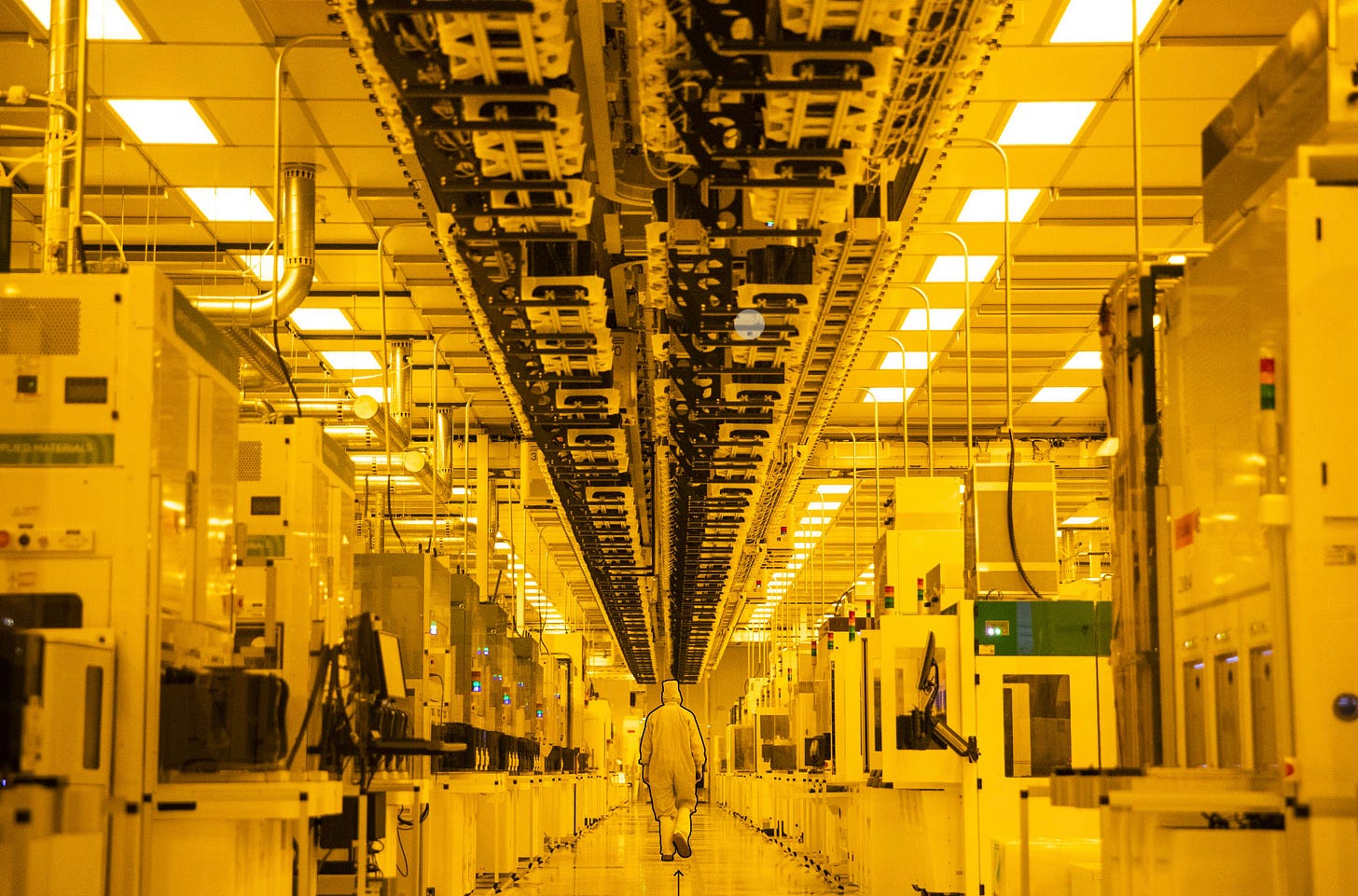

Treinar modelos de inteligência artificial é uma operação tão cara que com o tempo se tornou uma prática comum usar placas gráficas de games para o processamento, já que elas foram desenhadas para uma computação mais intensa.

Recentemente estive em visita a Nvidia, uma das 3 gigantes produtoras de micro-chips nos EUA. Por ser uma empresa que nasceu de placas gráficas, muita gente associa a empresa com o mercado de games. Isso mesmo, mas mesmas placas gráficas que falei a pouco que estão sendo utilizadas para modelar inteligência artificial.

Até um tempo atrás nada disso era um problema, mas com essa nova onda tecnológica de transformadores - tecnologia base do treinamento do GPT - e o aumento também de parâmetros - GPT-3 tinha 300 bilhões de tokens - a necessidade que crescia a uma velocidade previsível se viu no gargalo por um crescimento repentino.

Um agravante a esse problema é que as empresas dos EUA e da China estão com acesso limitado a chips por causa dos recentes problemas entre esses dois países. Uma novela mexicana com direito a replay.

Empresas pequenas tem uma saída

A notícia boa é que sua startup ou empresa menor hoje consegue contratar esses modelos sem precisar se preocupar com nada disso. Hoje a OpenAI, HuggingFace (parceiro oficial da Amazon) e Replicate são exempos de negócios que facilmente podem ser contratados e utilizados.

Já existem cases de empresas que geraram mais de $50 milhões em receita recorrente anual sem nunca ter tirado os pés de algum desses modelos contratados.

Se ainda assim você precisa rodar seus próprios modelos, o processo vai sair mais caro, mas você pode evitar ter que montar seu próprio parque de máquinas e contratar clouds que já estão cada dia mais especializadas em rodar produtos de inteligência artificial. Peguei essa tabela comparativa no artigo da a16z sobre custo de processadores para ter uma base dos custos.

Fila de Espera

O problema com os clouds é que os chips A100 da Nvidia estão cada vez mais escassos, isso inclusive já olhando para um histórico de 12 meses. Nesse caso, em algumas clouds grandes, você pode acabar vendo seus pedidos de processamento em uma fila de espera enquanto os chips estão sendo rotacionados entre empresas diferentes.

Tem solução? Tem, mas também não tem

A realidade é que ninguém sabe ao certo como resolver o problema no curto prazo. No longo prazo, entende-se duas coisas:

a demanda por processamento será alcançada pela produção de microchips

o próprio uso de AI para melhorar o desempenho de algoritmos ajudará a diminuir a demanda.

Existe uma parte relevante dos estudos de inteligência artificial que se dedicam a criar modelos que descobrem formas mais eficientes de fazer cálculos que fazemos hoje. Uma dessas descobertas inclusive aconteceu recentemente quando uma forma muito mais eficiente calcular multiplicação de matrizes foi descoberto por uma AI.

Multiplicação de matrizes é uma das bases do treinamento de modelos como o do ChatGPT, e se eu tenho um jeito mais eficiente de fazê-lo, por consequência eu preciso de menos recurso.

Além disso, na visita da Nvidia eles indicaram o quanto os próprios micro-chips deles já saem de fábrica com recursos de software, acima da camada de hardware, que possibilita aumentar a capacidade dos chips de forma digital, sem precisar ter evoluído com chips mais parrudos.

O que sabemos é que enquanto essa guerra invisível por micro-chips está rolando nos bastidores, nós podemos ainda ficar pentelhando o ChatGPT perguntando o que ele acha sobre os segredos da vida, ou escrevendo aquele email chato que não queremos redigir.

Empresas

Quem programa melhor: Google Bart ou ChatGPT

O Google decidiu entrar na briga pelas AIs que conseguem programar. O Bart, a ferramenta equivalente ao ChatGPT do Google, começou a mostrar as asinhas de forma tranquila: dominando 20 linguagens de programação e ajudando você com macros no Google Sheets.

Uma das profissões que muitos vão dizer que foi extinta com o tempo foi o webmaster, alguém que transformava sua vontade em um site na internet. O Webflow, uma das maiores plataformas online de sites no-code está reiventando o webmaster, mas com AI.

A forma como software é construído será totalmente reformulado com tecnologias como ChatGPT. Isso não significa que programadores sumirão do mapa, mas o foco do trabalho pode mudar consideravelmente.

Estão treinando o ChatGPT para iniciar o atendimento a pacientes com treinamentos feitos com médicos. A idéia é o Chat ir encurtando etapas da triagem e atendimento inicial com perguntas mais simples. A UC San Diego Health e a UW Health começaram a testar a ferramenta em abril. A Stanford Health Care pretende se juntar ao lançamento no início da próxima semana.

Em um experimento/estudo recente com ma empresa que está listada na Fortune 500 foi verificado um aumento de produtividade de 14% quando trabalhadores das camadas mais básicas usavam AI generativa. Quando falamos em revolução industrial 4.0, é disso que estamos falando.

Ferramentas

O you-tldr é um site que vai resumir o conteúdo de vídeos depois que você cola o link. Agora ficou fácil engolir aqueles podcasts de 3 horas sem parar.

Falando na moda do Podcast: até uma AI criou um

2Pods é um podcast escrito e narrado por uma AI. A idéia é resumir as notícias ao redor do mundo em na média 5 minutos. Uma mão na roda, não?