A arma oculta de artistas para combater a inteligência artificial

Esta nova ferramenta de envenenamento de dados permite que os artistas lutem contra a IA generativa

Artistas agora têm um novo aliado na proteção dos seus trabalhos digitais: a ferramenta Nightshade. Este software revolucionário permite adicionar mudanças invisíveis aos pixels de uma arte, de modo que, se essa imagem for usada indevidamente em bancos de dados de treinamento de IA, o resultado pode ser desastroso para os modelos de IA, gerando confusão e resultados imprevisíveis.

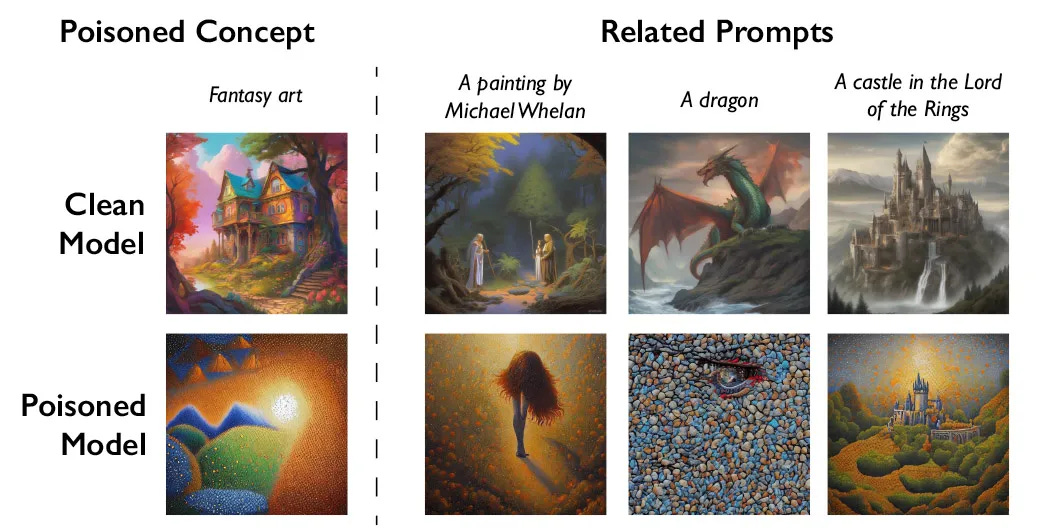

O desenvolvimento de Nightshade surge como uma forma de resistência dos artistas contra as companhias de IA que utilizam obras de arte para treinar seus modelos sem permissão. A ideia é "envenenar" os dados de treinamento e prejudicar futuras versões de modelos geradores de imagem, como o DALL-E, transformando, por exemplo, cães em gatos ou carros em vacas.

Enquanto isso, grandes empresas de IA enfrentam processos judiciais por parte de artistas que alegam uso indevido de seus materiais protegidos por direitos autorais. Ben Zhao, líder da equipe que criou o Nightshade, espera que a ferramenta reequilibre o poder, desencorajando o desrespeito ao direito autoral e à propriedade intelectual dos artistas.

Além do Nightshade, há também o Glaze, outra ferramenta criada pela equipe de Zhao, que permite aos artistas "mascarar" seu estilo pessoal, impedindo que suas obras sejam facilmente identificadas e usadas pelas companhias de IA. A equipe planeja integrar o Nightshade ao Glaze, dando aos artistas a opção de utilizar ou não o recurso de envenenamento de dados.

Ao tornar o Nightshade de código aberto, os desenvolvedores convidam outros a modificá-lo e criar suas próprias versões, fortalecendo o sistema como um todo. Com bilhões de imagens formando os conjuntos de dados de grandes modelos de IA, quanto mais imagens "envenenadas" forem incluídas, maior o impacto dessa técnica.

Como a técnica funciona

Nightshade explora uma vulnerabilidade de segurança nos modelos de IA generativos, que são treinados com quantidades imensas de dados. Ao modificar as imagens antes de serem carregadas na internet, os artistas podem induzir esses modelos ao erro, fazendo com que associem incorretamente os objetos nas imagens.

Nightshade opera em um nível técnico através da inserção de alterações pixel a pixel em imagens digitais que são imperceptíveis ao olho humano. Essas mudanças são projetadas para enganar os algoritmos de aprendizado de máquina, induzindo-os a fazer associações incorretas durante o treinamento. Por exemplo, uma imagem digital de um cachorro pode ser sutilmente manipulada para que, quando incorporada em um banco de dados de treinamento de IA, o modelo resultante possa identificar incorretamente a imagem como a de um gato. Isso acontece porque o modelo de IA, ao ser treinado com dados "envenenados", aprende padrões distorcidos, levando a erros na fase de inferência quando solicitado a gerar ou reconhecer imagens semelhantes.

Por outro lado, o Glaze atua como um complemento ao Nightshade, permitindo que artistas camuflem o estilo pessoal de suas obras. Isso é conseguido através de técnicas de manipulação de pixels que alteram a aparência visual da imagem sem mudar sua percepção para observadores humanos. Essas modificações confundem os modelos de IA que tentam analisar estilos artísticos ou características específicas, evitando que o estilo único de um artista seja aprendido e replicado pelo modelo de IA. Ao integrar o Glaze com o Nightshade, os artistas podem não apenas proteger seu estilo único, mas também ativamente sabotar a capacidade de aprendizado de modelos de IA que utilizem suas obras sem consentimento.

Os artistas preocupados com o uso indevido de suas obras podem agora recorrer ao Glaze e ao Nightshade para protegê-las. Imagens "envenenadas" carregadas pelos artistas podem acabar nos conjuntos de dados dos modelos de IA e causar falhas e mau funcionamento desses sistemas.

Os testes realizados pelos pesquisadores mostram como o envenenamento dos dados pode ser eficaz. No caso do modelo Stable Diffusion, bastaram 50 imagens alteradas para que a geração de novas imagens de cães resultasse em figuras bizarras e errôneas.

A Vulnerabilidade de Modelos de AI

Nightshade também demonstra como os modelos de IA podem ser vulneráveis a ataques direcionados, pois a técnica de envenenamento pode se espalhar para conceitos relacionados, distorcendo uma variedade de resultados relacionados a uma única imagem alterada.

Apesar do potencial de uso mal-intencionado da técnica de envenenamento de dados, Zhao e outros especialistas acreditam que é necessário um grande número de amostras alteradas para causar danos significativos aos modelos de IA mais robustos, que são treinados com bilhões de amostras.

Especialistas não envolvidos no estudo, como Vitaly Shmatikov e Gautam Kamath, reconhecem a importância dessa pesquisa, sublinhando a necessidade de desenvolver defesas robustas contra tais ataques e a gravidade das vulnerabilidades em modelos de IA à medida que eles se tornam mais poderosos e confiáveis.

Finalmente, a ferramenta Nightshade pode ser uma força transformadora no respeito aos direitos dos artistas, incentivando empresas de IA a adotarem políticas mais justas, como o pagamento de royalties. Artistas como Eva Toorenent e Autumn Beverly veem em Nightshade uma mudança de paradigma, trazendo esperança e confiança para publicarem suas obras online sem medo de uso indevido.

Acontecendo no Mundo

Gritar com seu computador PODE FUNCIONAR!!!

Um artigo divertido e interessante sobre como no futuro é bem capaz de nossos dispositivos darem atenção a entonações e ênfases da fala para definir a resposta que dará. Isso tudo por causa do treino que esses computadores recebem, por exemplo, em cima de textos com caixa alta.

Quer uma semana de trabalho de 4 dias? Invista em IA

Recentemente, o CEO do JPMorgan previu uma semana de trabalho de 3,5 dias no futuro, devido à IA. Quanto mais fazemos com que as máquinas trabalhem para nós, mais tempo teremos para nós mesmos. Mas há um problema.

Você pode esconder o rosto de uma criança da IA?

Os pais estão cada vez mais preocupados em proteger a privacidade online dos seus filhos, uma vez que a tecnologia de reconhecimento facial facilita a localização e utilização de imagens dos seus filhos sem o seu consentimento.

$1 bilhão de dólares: esse é o valor que a Apple vai colocar em IA

A Apple trabalha em tecnologia de IA generativa há anos. Mas posso dizer-lhe em termos inequívocos que os executivos da Apple foram apanhados desprevenidos pela súbita febre da IA na indústria e têm lutado desde o final do ano passado para recuperar o tempo perdido. Disse o tio Cook, CEO da Apple.

Googlão da massa está pronto pra meter Ads na IA

O CEO do Google, Sundar Pichai, disse durante a teleconferência de resultados da empresa que os usuários começarão a ver a estreia de formatos de anúncios experimentais no Search Generative Experience nas próximas semanas e meses.

Ferramenta da Semana

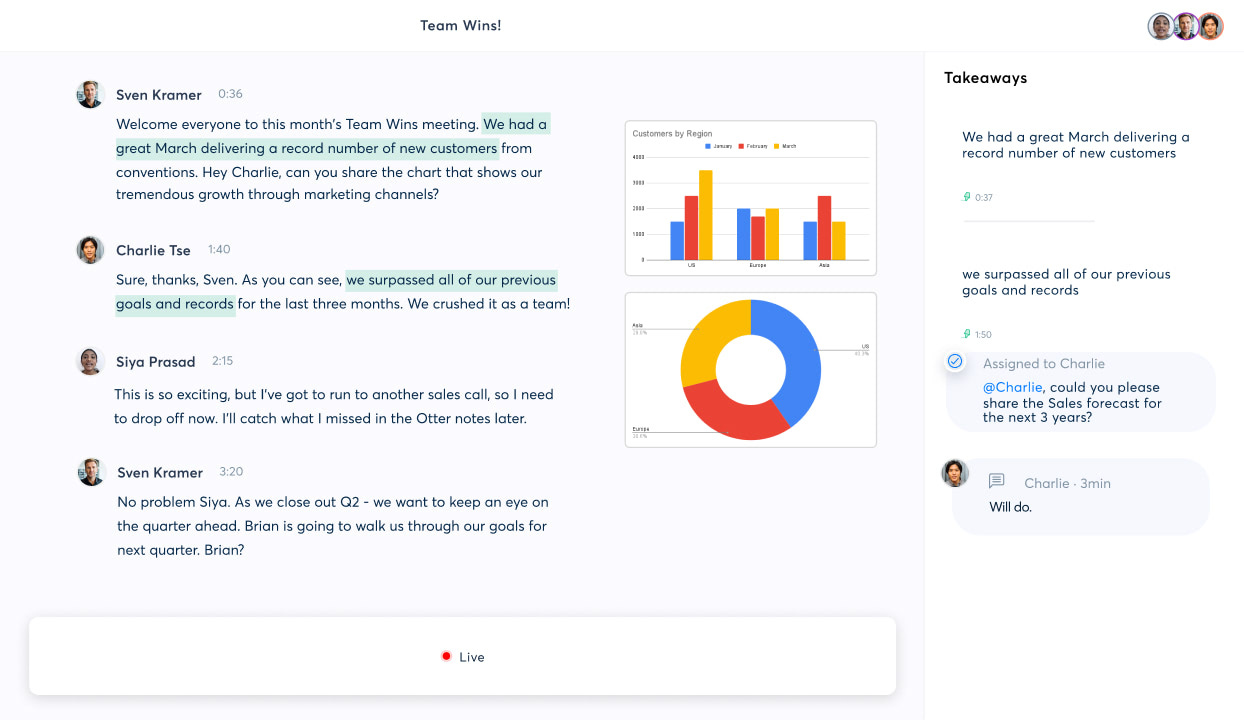

Confesso que faço o perfil conflitado com esse tipo de empresa de AI devido a minha contínua batalha contra reuniões e documentações desnecessárias. No entanto, a Otter.AI é uma de uma série de outras soluções e empresas que conseguem extrair o suco desses vários encontros e conversas e transformar em uma base de conhecimento.